Tipps und Tricks für die Durchführung eines erfolgreichen A/B-Tests

Die Durchführung von Feldexperimenten ist nicht so einfach, wie es auf den ersten Blick scheint. Basierend auf den Erfahrungen einer umfangreichen Studie, die über 8 Monate mit der Universität Zürich durchgeführt wurde, werden im Folgenden die wichtigsten Erkenntnisse zusammengefasst. Diese Studie war Teil eines grösseren Forschungsprojekts der UZH.

In der heutigen vielfältigen, komplexen und schnelllebigen Digital-Marketing-Landschaft kann es eine grosse Herausforderung darstellen, genau zu verstehen, welche Auswirkungen Ihre Marketingkampagnen auf Ihre Ergebnisse haben.

Sind die Verkäufe aufgrund der neuen Display-Kampagne, die Sie gerade gelauncht haben, gestiegen – oder lag es daran, dass der Start der Kampagne zufällig mit einem anderen Faktor zusammenfiel, etwa mit einem saisonalen Ereignis wie Ostern oder, wie beispielsweise im Jahr 2020, weil ein pandemiebedingter Lockdown ausgerufen wurde.

Natürlich kommt mit der Erfahrung auch das Wissen und Sie können wahrscheinlich erkennen, wie verschiedene Marketing-Channels und äussere Faktoren aufeinander wirken. Aber was ist, wenn Sie eine neue Marketinglösung testen oder eine neue, innovative Technologie einsetzen?

Hier kommen A/B-Tests ins Spiel. Sie sind ein wichtiger Bestandteil des Werkzeugkastens eines Marketers und eine hervorragende Möglichkeit, um zu verstehen, welche Auswirkungen ein bestimmtes Element Ihrer Marketingaktivitäten auf den Outcome hat.

In Zusammenarbeit mit der Universität Zürich hat nexoya genau einen solchen A/B Test durchgeführt.

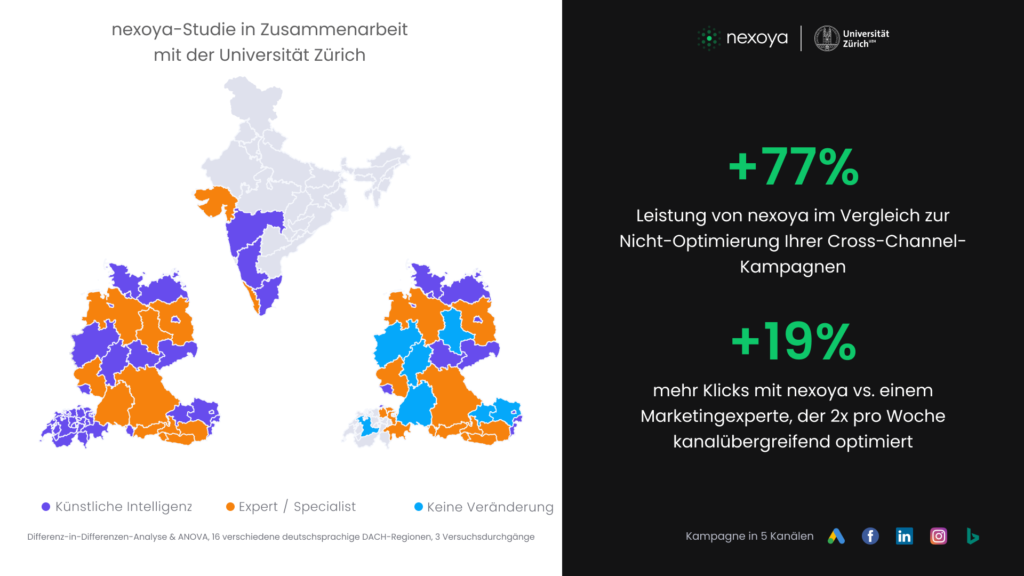

Für ihre Masterarbeit wollte Flavia Wagner nachvollziehen, wie sich der Einsatz von KI im Vergleich experten-basierter Optimierung auf die Marketing-Performance auswirkt. nexoya war die perfekte Lösung für das Experiment: Wir setzen KI ein, um Channel-übergreifende Marketingbudgets zu optimieren und so auf dynamischer, fortlaufender Basis die ideale Verteilung der Ausgaben für eine bestmögliche und möglichst kostengünstige Performance zu gewährleisten.

Wagners Hypothese war einfach: Bringt die KI-gestützte Budget-Optimierung eine bessere Performance als die von einem Optimierung eines Marketingexperten?

Da dieses Experiment für eine Masterarbeit diente, die strengen Anforderungen der Universität standhalten müssen, war es wichtig, dass die A/B Tests sorgfältig nach akademischen Standards aufgesetzt werden. Der goldene Standard sind randomisierte Feldexperimente, die zuverlässige und verallgemeinerbare Schätzungen des Effekts liefern. Gestützt auf den über 6 Monate gesammelten Daten konnte Wagner schlussfolgern, dass die KI-gesteuerte Budgetoptimierung von nexoya 19% mehr Klicks brachte als der Marketingexperte und 77% mehr Klicks als die Kontrollgruppe.

Dank des A/B-Tests konnten wir schlüssig nachweisen, welchen Effekt unser Marketingtool auf die Kampagnenergebnisse hatte.

Basierend auf dieser Erfahrung finden Sie nachfolgend unsere Tipps und Tricks für die Durchführung von A/B-Tests:

Planen Sie eine Kontrollgruppe ein

- Mit einer Aktivitäts-Baseline, während der keine Änderungen vorgenommen werden, können Sie sicherstellen, dass die Ergebnisse nicht durch äussere Faktoren in einer der Testgruppen verfälscht werden und in der anderen nicht. In jeder unserer beiden Versuchsrunden liessen wir unsere Kampagnen 7 Tage lang laufen, ohne Änderungen vorzunehmen, bevor wir mit der Optimierung begannen. Im zweiten Experiment hatten wir ausserdem über die gesamte Zeit eine Kontrollgruppe laufen, um zu sehen, wie sowohl nexoya als auch der Experte im Vergleich zu einer Marketingkampagne ohne Budgetoptimierung abschneiden würden.

Seien Sie sorgfältig bei der Aufteilung Ihrer Testgruppen

- Es gibt viele verschiedene Möglichkeiten für die Aufteilung der Testgruppen, aber es ist entscheidend, das alle Einflussfaktoren berücksichtigt und kontrolliert werden. Insbesondere ist es wichtig, dass es keine Wechselwirkungen oder Überschneidungen zwischen den Gruppen gibt. Bei den Experimenten von nexoya x UZH haben wir die Kampagnen der verschiedenen Gruppen auf unterschiedliche geografische Regionen ausgerichtet. Um sicherzustellen, dass die Grösse und die Interessen der Audience in den verschiedenen geografischen Blöcken möglichst gleich waren, haben wir die Blöcke auf der Grundlage von Faktoren wie Bevölkerung, BIP, Interesse der Audience (z. B. die Anzahl der für unser Produkt relevanten Technologieunternehmen) und Suchvolumen aufgesetzt.

Sorgen Sie für genügend statistische Aussagekraft (power)

- Um sicherzustellen, dass die Ergebnisse generalisierbar sind, ist eine ausreichende statistisch Aussagekraft (power) sehr wichtig. Unser A/B-Test wurde in vier separaten Geo-Blöcken durchgeführt, in denen die Budgets als einzelne Kampagne optimiert wurden, so dass wir im Wesentlichen vier Gruppen pro Treatment hatten. Dadurch konnten wir die statistische Aussagekraft erhöhen, und so ein statistisch signifikante Ergebnisse erzielen. Generell gilt: Je mehr Daten, desto besser.

Kontrollieren Sie so viele Faktoren wie möglich beim Setup

- Dies mag ziemlich offensichtlich erscheinen, aber wenn man mehrere Kampagnen in mehreren Channels durchführt, entgehen einem manchmal Dinge. Es ist entscheidend, dass Sie bei der Anpassung einer Kampagne in Gruppe A (beispielsweise das Zielgruppe die gleiche Anpassung auch in Gruppe B vornehmen. Andernfalls ist es äusserst schwierig zu sagen, dass z. B. die Budgetoptimierung der Grund dafür war, dass eine Gruppe besser abschnitt als die andere. Wenn Sie dies sorgfältig kontrollieren, wird viel deutlicher, was tatsächlich einen Einfluss auf die Performance hat.

Verwenden Sie geeignete statistische Modelle

- Marketer betrachten die Ergebnisse eines A/B-Tests oft in ihrem Rohformat (d. h. Gruppe A erzielte 400 Conversions und Gruppe B 500, also schnitt Gruppe B besser ab). Wenn Sie jedoch eine statistische Analyse des Tests durchführen, erhalten Sie wesentlich solidere Ergebnisse. Daher ist es wichtig, dass Sie die richtigen Modelle für Ihre Analyse auswählen. In unserem Fall haben wir für die Analyse der Ergebnisse Differenz-von-Differenzen und ANOVA verwendet.

A/B-Tests sind letztlich eine sehr leistungsfähige und dennoch relativ unkomplizierte Möglichkeit, um herauszufinden, wie sich Ihre verschiedenen Marketingmassnahmen tatsächlich auf Ihre Ergebnisse auswirken.

In unserem Fall lautet die Schlussfolgerung: Ja, eine KI-gestützte Budgetoptimierung erzielte eine bessere Performance als die gleiche, von einem Marketingexperten durchgeführte Optimierung – genauer gesagt um 19% besser.

Besonderer Dank gilt Flavia Wagner und Dr. Markus Meierer von der Universität Zürich für diese Zusammenarbeit.